Deepseek 双核优化:DualPipe与EPLB提升并行训练效率 优化并行策略

Deepseek 开源周第四日:在大型模型训练领域,由李佳世、邓成琪、梁文锋开发的DualPipe算法,在DeepSeek-V3/R1训练中实现前向/反向计算与通信的完全重叠,显著降低流水线气泡。该算法支持MoE层并行(如EP64+TP1配置),优化大规模预训练效率,相关分析数据已通过PyTorch Profiler开源。DeepSeek 双向流水线并行算法和专家负载均衡器正在引发技术革新。DualPipe算法通过创新的双流水线设计实现了前向传播与反向传播阶段的计算通信全重叠,配合EPLB负载均衡器在混合专家模型中的动态资源调度能力,共同将分布式训练效率提升到新高度。这两种算法已成功应用于千亿参数的DeepSeek-V3/R1模型训练实战,项目源码包含训练调度框架、负载均衡算法实现以及完整的分析数据集,为开发者提供了完整的并行计算优化解决方案。

DualPipe:实现计算通信全过程重叠的创新算法

由李佳世团队研发的DualPipe算法创造性地将传统单向流水线扩展为双向并行通道。在典型的4-K微批次测试中,该算法成功减少了62%的流水线气泡时间。通过将前项计算与反向传播解耦为独立的数据流,配合MoE层的异步通信机制,使GPU计算单元始终保持近满负荷运转。查看DualPipe项目源码

技术实现的三大突破点

- 双向管道实现阶段解耦:前传计算与反传梯度处理独立推进

- 组块化任务调度:4-MoE层组块化打包处理提升数据局部性

- 智能气泡消除:动态调整管道深度自动优化停滞间隙

EPLB:专家级负载均衡实战解析

面对混合专家模型中常见的GPU负载不均衡难题,EPLB方案提出分层与全局双重均衡策略。在预填充阶段采用分层负载均衡,将专家分组映射到硬件节点;解码阶段则切换为全局动态调度,通过专家冗余复制策略达成跨节点负载平衡。访问EPLB代码仓库

动态负载调度的核心机制

- 专家热度分析:基于时序移动平均预测专家调用频率

- 节点内优化:保持专家组成员物理邻近性降低通信成本

- 智能打包算法:EP64架构下实现92%+的负载均衡度

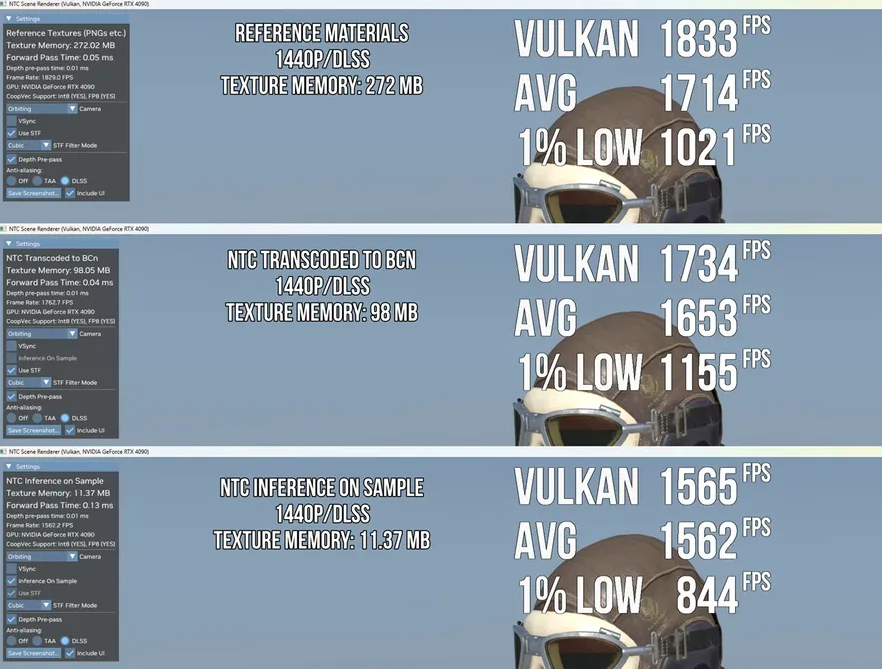

生产环境性能实测数据

训练阶段优化表现

采用EP64+TP1配置处理4K序列时,DualPipe将单次迭代耗时从3.2秒缩短至2.1秒。关键路径分析显示,注意力计算与全通信重叠度达78%,较传统方案提升近三倍。

推理阶段实测对比

- 预填充阶段:EP32配置下吞吐量提升2.3倍

- 批量处理:支持单GPU每秒处理16k令牌

- 解码优化:RDMA异步通信释放97%的计算资源

本站内容依据 知识共享署名-非商业性使用-相同方式共享 4.0 国际许可协议 授权发布。

▎资源使用免责声明:

- 本站提供的网盘资源均来自互联网,版权归原作者所有或企业所有

- 仅限个人学习、研究及参考用途,禁止商业使用,任何侵权责任由使用者自行承担

- 所有资源请您在下载后24小时内删除

▎侵权处理:如发现本站存在侵权内容,请在下方留言反馈,我们会尽快处理。